随着OpenAI、Anthropic、Google和微软等公司的生成式AI及大语言模型(LLM)用户量呈指数级增长,企业IT安全决策者正努力跟上AI技术的快速发展步伐。非营利组织OWASP最新发布的《LLM AI网络安全与治理清单》(PDF)正是为此而生。

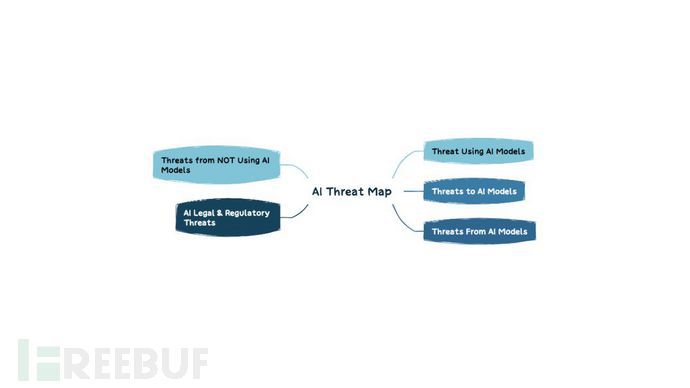

LLM威胁分类体系

鉴于AI领域涉及面广泛,OWASP清单主要帮助管理者快速识别生成式AI和大语言模型的关键风险并采取补救措施,确保企业具备基本安全控制能力来安全使用相关工具和服务。OWASP强调该清单将随技术成熟度持续更新,其专家团队将LLM威胁划分为以下类别:

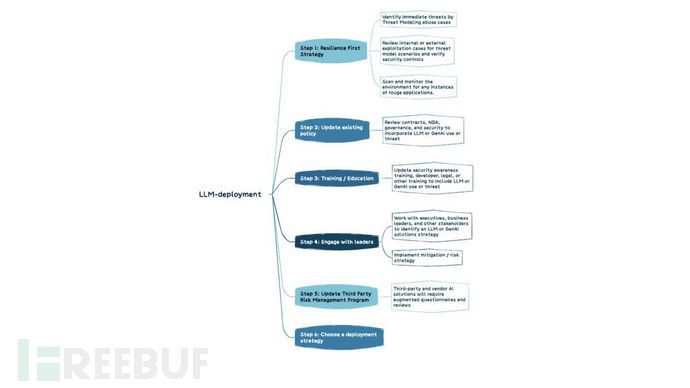

制定LLM战略时,企业需重点应对生成式AI带来的独特风险,通过组织治理和安全控制加以缓解。OWASP建议采用六步法构建有效的LLM部署策略:

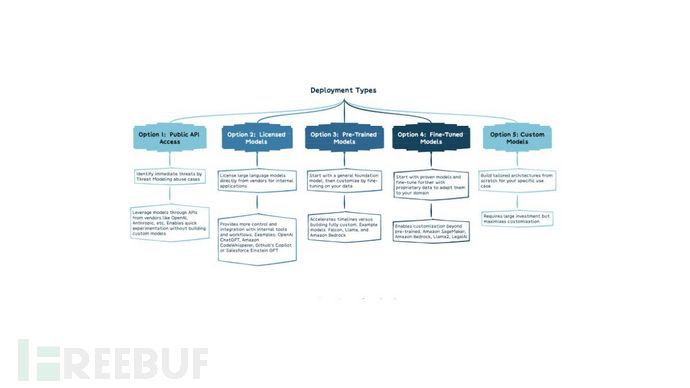

针对不同类型的LLM部署方案,OWASP也提供了详细考量框架:

OWASP AI安全清单详解

(1) 对抗性风险

涵盖竞争对手和攻击者双重维度,包括分析竞对如何运用AI提升业务表现,以及更新事件响应计划等内部流程以防范AI相关安全事件。

(2) 威胁建模

基于"安全设计"原则,需考虑攻击者如何利用LLM加速漏洞利用、企业如何检测恶意AI行为,以及如何实施系统防护措施。

(3) AI资产清点

遵循"未知即不可保护"原则,需全面记录自研解决方案和第三方工具,明确责任归属。建议将AI组件纳入软件物料清单(SBOM),按敏感度分类数据源,并建立工具准入退出机制。

(4) AI安全与隐私培训

通过系统化培训使员工理解AI/LLM技术原理与安全挑战,培育信任透明的组织文化,从根本上杜绝"影子AI"现象。

(5) 商业价值论证

避免跟风炒作,需建立清晰的AI商业用例,如同当年云计算推广时的战略规划。

(6) 治理框架

通过RACI矩阵明确AI项目权责,制定企业级政策和流程,实现可问责的管理体系。

(7) 法律合规

需法律团队介入评估产品担保条款、最终用户许可协议(EULA)和知识产权风险等关键法律议题。

(8) 监管应对

密切关注欧盟《人工智能法案》等新兴法规,识别适用的合规要求。

(9) LLM方案实施

具体控制措施包括:实施访问控制、保护训练管道、映射数据流、识别LLM及供应链漏洞,建议定期进行第三方审计、渗透测试和代码审查。

(10) 测试评估验证(TEVV)

参照NIST AI框架建议,持续开展功能测试、安全验证及可靠性评估,覆盖AI模型全生命周期。

(11) 模型与风险卡片

通过标准化文档披露模型架构、训练方法和性能指标,提升系统透明度,主动应对偏见、隐私等伦理问题。

(12) 检索增强生成(RAG)

通过优化预训练模型和增量训练,提升LLM在特定数据源的检索能力,最大化企业应用价值。

(13) AI红队演练

通过模拟攻击检验防御体系有效性,但需明确演练边界要求,避免引发合规风险。